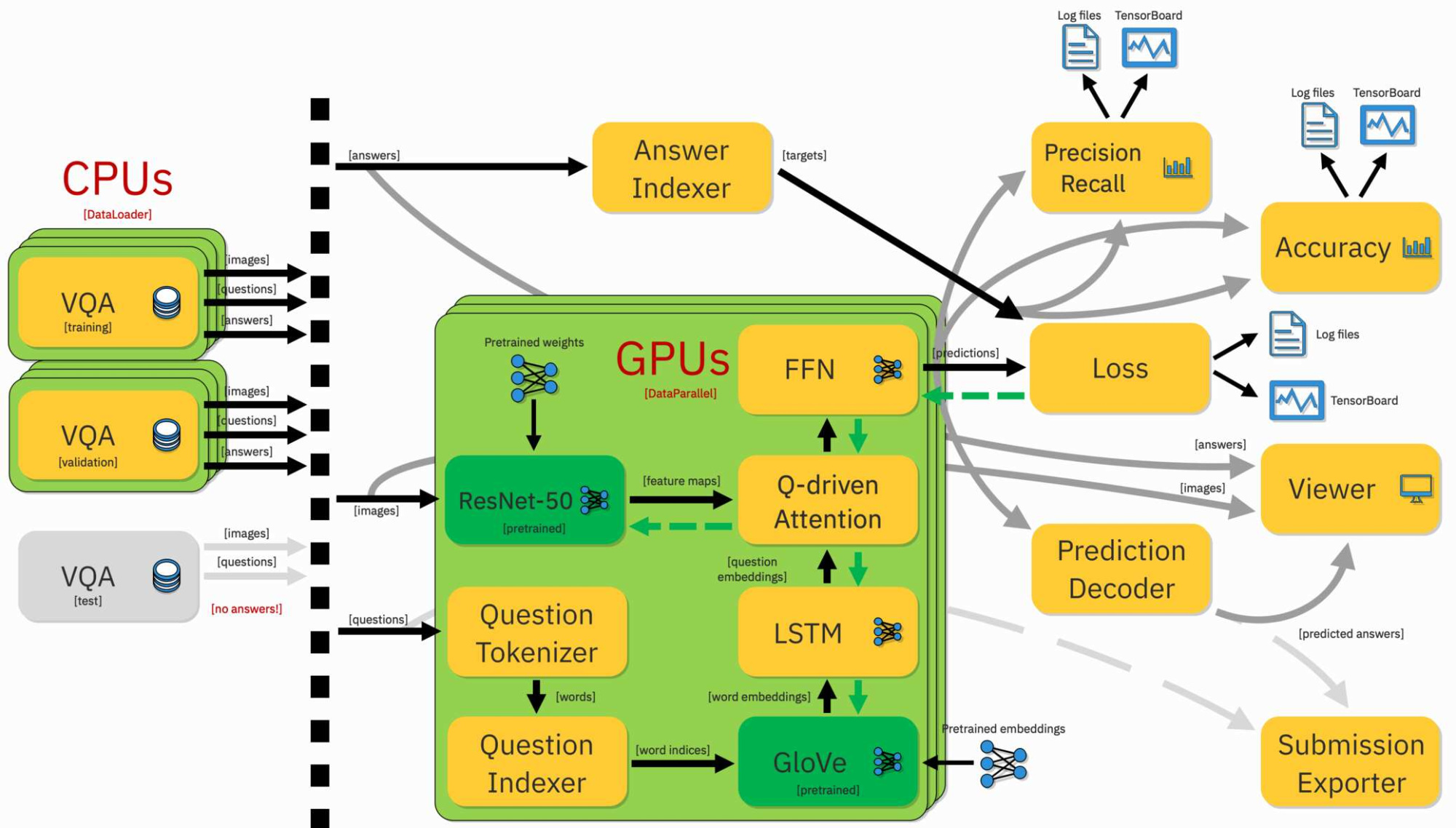

Машинное обучение (ML) и глубокое обучение (DL) требуют мощных вычислительных ресурсов для эффективного обучения сложных моделей на больших объемах данных. При выборе GPU-сервера для обучения ML-моделей можно учитывать как локальные варианты, так и облачные сервисы. Но при действительно сложных вычислениях трудно найти что-то производительнее и лучше масштабируемой виртуальной инфраструктуры с возможностью подключения нужного количества серверов с GPU.

Особенности локальных GPU-серверов

Почему локально расположенное «железо» часто проигрывает облачной инфраструктуре?

Преимуществом собственного оборудования является полный контроль над ним и используемым программным обеспечением. Это может быть критичным требованием для развития проекта. Ещё одно преимущество — более высокая пропускная способность. В виртуальных серверах нет возможности отдавать 100% ресурсов под задачи клиента — какую-то небольшую часть всё равно съедает виртуализация.

При всём при этом локальное оборудование обходится недёшево, ведь покупка и поддержка локального оборудования требует значительных инвестиций. Ещё один недостаток — возможности масштабирования локальных серверов ограничены физическими ресурсами, что может стать проблемой при обучении крупных моделей.

Облачные сервисы позволяют масштабировать вычислительные ресурсы в зависимости от потребностей проекта. Пользователи могут выбирать конфигурации серверов и GPU в соответствии с требованиями конкретных задач. Практика показывает, что облачные сервисы предоставляют гибкость и масштабируемость, но могут стоить дорого, если много и долго обучать нейросети с привлечением большого количества серверов с GPU. Исходя из этих факторов, разработчики могут принимать обоснованные решения, выбирая оптимальный GPU-сервер для своих задач машинного обучения.

GPU-сервер для обучения нейронных сетей — базовые параметры

Главное условие, самом собой, наличие производительного графического ускорителя. У GPU важны тензорные ядра и скорость. Тензорные ядра быстрее CUDA-ядер, так как выполняют меньше циклов во время операций с матрицами. Но из-за своей скорости они могут подолгу простаивать, ожидая поступление информации из глобальной памяти. Поэтому производитель предлагает карты, где есть CUDA и тензорные ядра.

Производительность ядер тоже важна. Ориентироваться нужно именно на этот параметр, а не на количество ядер. Пропускная способность памяти определяет скорость выполнения вашей задачи. И уже потом можно смотреть на размер разделяемой память (Shared Memory) и кэш L1, которые снижают количество обращений к внешней памяти и держат данные ближе к GPU. Что тоже хорошо для скорости работы сервера.

На ноябрь 2023 года рекомендуют использовать GPU, в которых не меньше 11 Гб видеопамяти. Да, какие-то базовые процедуры в глубоком обучении можно выполнять, работая с небольшими датасетами. Для каких-то личных проектов достаточно даже 8 Гб видеопамяти.

GPU, в которой 11 ГБ и больше видеопамяти, рекомендуется для работы с нейросетями-трансформерами, обработке медиаконтента в высоком разрешении, распознавании медицинских снимков, компьютерным зрением и другими проектами с большим объёмом входных параметров и сложными вычислительными процессами.

Несмотря на всю мощь графических ускорителей в плане производительности перед CPU, без последнего не обойтись. Но не для обучения нейросетей, а для подачи предобработанных данных в GPU. Процессорное время требуется именно для подготовки таких данных. Но важно, чтобы это был многопоточный CPU либо CPU с высокой частотой.

Не стоит экономить и на RAM. Пусть будет 32 Гб, для большинства проектов этого достаточно. Если нужно изменить объём памяти — это вполне возможно, но может потребовать остановки сервера.

Забудьте про HDD и используйте SSD для работы с нейросетями. Они быстрые и надёжные, а требуемый объём SSD зависит от размера вашего датасета. Желательно, чтобы SSD был с поддержкой NVMe.

Популярные модели GPU для ML-обучения

Как вы наверняка знаете, под разные задачи используются разные GPU-карты. Подробнее о популярных видеокартах для машинного обучения мы уже рассказывали.

Генерация хэшей, 2D графика и трёхмерное моделирование требуют разный объём ресурсов и набор ПО. В зависимости от задач мы предлагаем сервера с GPU NVIDIA® Tesla® V100, P100, M60, M40, RTX 3060-3090 и RTX 4060-4090. Если у вас большой проект с 3D моделями или требуется быстро выполнить сложные вычисления, то в этом случаем может подойти аренда рендер-фермы на базе графических ускорителей Tesla M40.

Сервера с какими моделями GPU чаще всего встречаются в проектах, где занимаются обучением нейронных сетей? Можно назвать большое количество видеокарт, мы остановимся на трёх.

NVIDIA GeForce RTX 3090

NVIDIA GeForce RTX 3090 — производительная видеокарта для геймеров, которая может успешно применяться в ML. Её 24 гигабайта памяти и высокая вычислительная мощность делают её привлекательным выбором для обучения моделей.

AMD Radeon Instinct MI100

AMD также предоставляет мощные GPU, такие как Radeon Instinct MI100, обладающий высокой производительностью при выполнении вычислений с плавающей запятой.

NVIDIA Tesla V100

NVIDIA Tesla V100 является одним из наиболее мощных и эффективных GPU для обучения моделей глубокого обучения. Этот графический ускоритель получил комплект тензорных ядер и способен обеспечить высокую производительность при работе с большими датасетами. Опишем эту модель более подробно, поскольку именно на ней выполняется значительная часть проектов в мире machine learning. Именно на чипах NVIDIA идёт сейчас ИИ-революция.

В чём особенность GPU-сервера для обучения нейронных сетей на базе NVIDIA Tesla V100?

- Тензорные ядра. NVIDIA Tesla V100 оборудован тензорными ядрами, специально разработанными для ускорения операций над тензорами, что делает этот GPU особенно эффективным при обучении нейросетей.

- 5 120 ядер CUDA. Благодаря 5 120 ядрам CUDA, Tesla V100 обеспечивает высокую параллелизацию и эффективен при тяжёлых вычислениях, что актуально при работе с глубокими нейронными сетями.

- HBM2 память. Использование высокоскоростной HBM2 памяти позволяет быстро обращаться к большим объемам данных, что существенно ускоряет процесс обучения моделей.

- NVLink технология. NVIDIA Tesla V100 поддерживает технологию NVLink, и может объединять несколько GPU в единую систему с высокой пропускной способностью и минимальной задержкой.

Высокая производительность Tesla V100 обеспечивает позволяет сократить время обучения моделей. Тензорные ядра делают эту карту идеальным выбором для работы с тензорными вычислениями, широко используемыми в глубоком обучении. А возможность использования нескольких GPU с поддержкой NVLink обеспечивает высокую масштабируемость при работе с крупными датасетами и сложными моделями.

Преимущества использования GPU-сервера Cloud4Y для обучения нейросетей

- Позволяет работать с machine learning, deep learning, neural networks, AI

- Вам доступны все преимущества работы с облачными вычислениями

- Вы получаете высочайшую производительность сразу, не теряя время на закупку, монтаж и обслуживание

- Вы используете тот объём ресурсов, который нужен для решения задачи в заданные сроки

- Вы работаете с материалом на обычном компьютере или ноутбуке

- Вы можете одновременно работать с несколькими моделями AI

- Гарантированная доступность сервисов 99.982%

- Доступная 24/7 техподдержка

Заключение

Облачные серверы с GPU для обучения нейронных сетей— эффективное решение для компаний, которые желают сэкономить на создании собственной ИТ-инфраструктуры, не отказываясь при этом от высокопроизводительных вычислений и работы с большими объёмами данных. Аналитика, расчёты, рендер, машинное обучение — вы можете использовать GPU-фермы для решения разных задач.

GPU-ферма Cloud4Y — массив высокопроизводительных профессиональных графических ускорителей Tesla M40. Данное серверное решение ориентировано на задачи, связанные с поддержкой машинного обучения, глубокого обучения, тренировки нейросетей, для работы с искусственным интеллектом. Видеопроцессор и память оптимизированы для работы в бесперебойном режиме 24х7.

Важно! Ваше ПО должно иметь возможность выбора конкретной видеокарты для выполнения нужных действий. Приложения, которые обращаются только к видеокарте, используемой по умолчанию в системе, не смогут работать с виртуальными GPU. Рекомендуем использовать ПО, которое умеет обращаться к видеокартам из присутствующих в ОС. Если у вас есть вопросы по этому пункту, рекомендуем обратиться к менеджеру или техническому специалисту Cloud4Y. Вам помогут разобраться в ситуации и предложат оптимальную конфигурацию виртуального сервера.