Обучение языковых моделей, генерация изображений, анализ видео — сегодня всё это работает на GPU. Они являются ключевым компонентом современных AI-систем, однако их эксплуатация требует значительных финансовых вложений. Если использовать GPU бездумно, бюджет на вычисления может легко выйти из-под контроля.

В этой статье мы разберемся, как заставить каждый рубль, вложенный в GPU, работать на полную — и при этом значительно сократить расходы, не теряя в скорости и качестве.

Почему GPU-вычисления — это так дорого?

Стоимость профессионального ускорителя вроде NVIDIA H100, сравнимая с ценой автомобиля, — это только начало. Для эффективной работы ускорителя необходима дорогостоящая инфраструктура:

-

Мощный сервер, способный обеспечить необходимую пропускную способность данных.

-

Система электроснабжения, так как топовые сборки потребляют киловатты энергии.

-

Системы охлаждения для поддержания безопасного теплового режима.

Возникает вопрос: почему не использовать игровые карты, которые стоят дешевле? Здесь всё дело в надёжности и оптимизации под другие задачи. Серверные GPU созданы для работы 24/7, имеют память с коррекцией ошибок (ECC) и, что немаловажно, их драйверы и лицензии позволяют легально использовать такие карты в дата-центрах. Плюс, только профессиональные ускорители эффективно объединяются в большие кластеры для обучения по-настоящему масштабных AI-моделей.

Наконец, не стоит забывать про ажиотажный спрос. Бум генеративных нейросетей создал дефицит, который увеличил цены не только на покупку, но и на аренду в облаке. Поэтому без системного подхода к управлению расходами бюджет на AI/ML может выйти из-под контроля.

Подберите правильный GPU. Не всегда нужен самый мощный

Использовать топовый H100 под все задачи — нерационально. Первый и самый важный шаг к экономии — это right-sizing, то есть правильный подбор оборудования под конкретную задачу.

Ключевое различие здесь — это обучение (training) и инференс (inference).

-

Обучение (Training) — это построение модели с нуля. Для этого требуются высокопроизводительные ускорители, такие как NVIDIA H100 или A100. Они месяцами обрабатывают большие объемы данных, чтобы создать рабочую AI-модель.

-

Инференс (Inference) — это использование уже готовой модели. Она получает запрос (например, текст для перевода) и выдаёт результат. Здесь важны скорость отклика (latency) и эффективность использования ресурсов, а не максимальная вычислительная мощность.

Для задач инференса подходят карты типа NVIDIA L4 или T4. Они оптимизированы для обработки большого числа запросов с минимальными затратами. Существуют также универсальные решения, например NVIDIA L40S, которые подходят и для дообучения (fine-tuning), и для сложного инференса.

Следите за загрузкой

Правильно подобранная карта не спасет бюджет, если GPU простаивает большую часть времени. Аренда мощного сервера с низкой загрузкой приводит к неоправданным расходам. Важно навести порядок в управлении ресурсами.

-

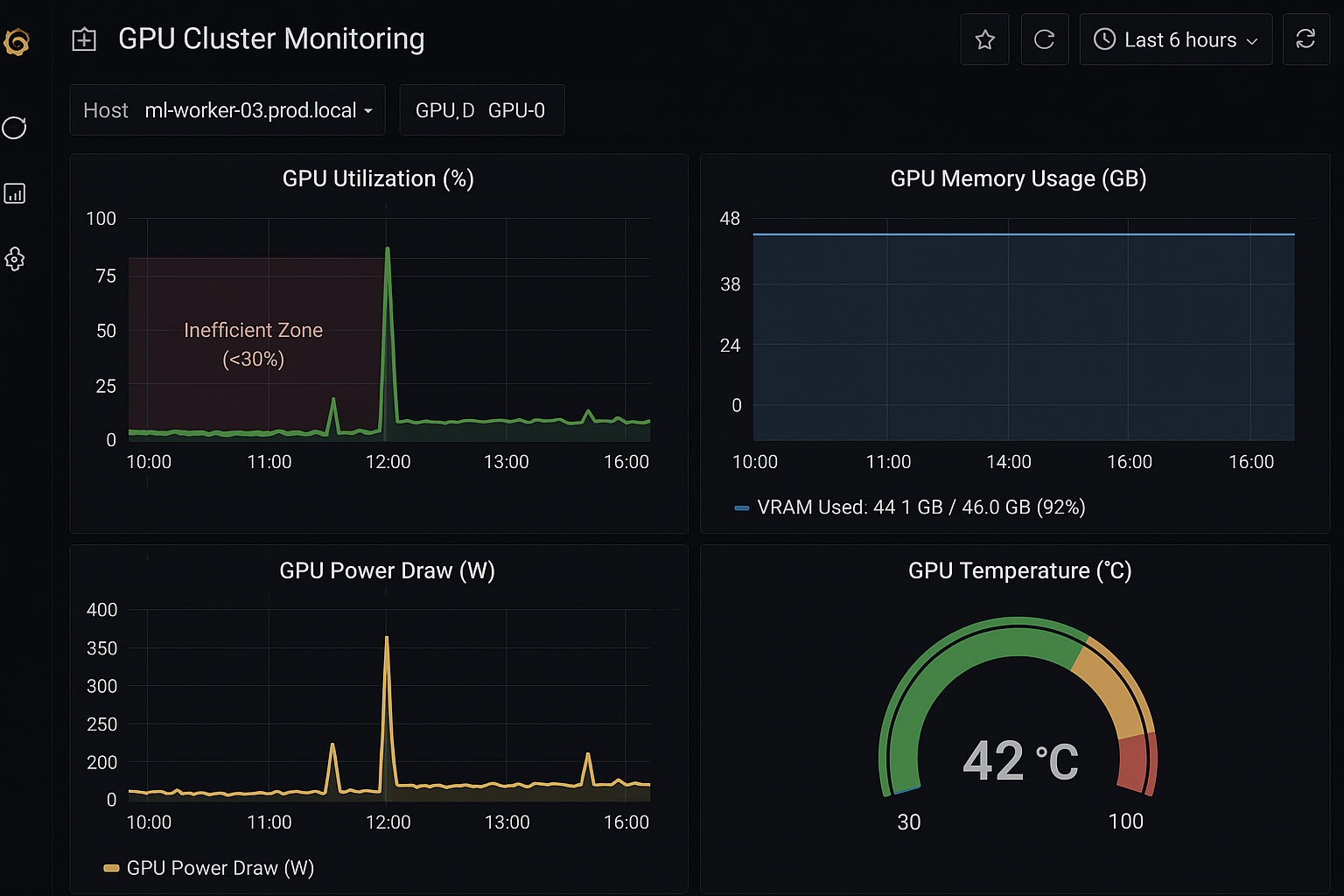

Начните с аудита. Запустите nvidia-smi на своих машинах или настройте простые дашборды в Grafana, чтобы получить реальную картину использования. Если утилизация GPU (GPU-Util) большую часть времени ниже 90%, ресурсы используются неэффективно.

-

Планируйте запуски. Для повышения загрузки создайте очередь задач и избегайте хаотичного запуска процессов. Долгие и ресурсоемкие задачи можно запускать в ночное время или в выходные, когда общая нагрузка на инфраструктуру минимальна. Это освобождает ресурсы для критически важных задач в рабочее время.

-

Автоматизируйте "включение" и "выключение". GPU-инстансы, остающиеся активными после завершения задач, приводят к ненужным расходам. Настройте автоматическое завершение работы машин после выполнения задач.

-

Делите ресурсы, а не серверы. Если у вас несколько проектов, не выделяйте каждому по отдельному GPU. Используйте технологии виртуализации GPU, такие как NVIDIA MIG, или управляйте доступом через оркестраторы вроде Kubernetes. Это позволяет одному ускорителю одновременно обслуживать несколько задач и повышает его загрузку.

Эффективное управление и планирование использования GPU — ключевой элемент оптимизации расходов в AI/ML.

Выберите правильную среду для запуска

После того как оборудование выбрано, а задачи распределены, встаёт ключевой вопрос: в какой среде выполнять вычисления. От этого зависит не только удобство, но и значительная часть затрат. Есть два основных подхода:

Управляемые сервисы

Создание собственного Kubernetes-кластера, настройка драйверов и системы мониторинга требует немалых временных и денежных затрат. Управляемые AI/ML-платформы позволяют использовать готовую инфраструктуру, что упрощает запуск и сопровождение проектов.

Такое решение, как готовый GPU сервер от Cloud4Y, позволяет сосредоточиться на главном: на Data Science и на разработке самой модели, вместо администрирования серверов. Это идеальный вариант для команд, которые хотят получить результат быстро и без лишних затрат на DevOps-экспертизу.

Гибридное облакоДля компаний, у которых уже есть своё железо, гибридный подход часто становится рациональным решением. В этом случае собственные серверы используются для постоянных нагрузок, а облачные ресурсы подключаются для пиковых задач или временных экспериментов. Интеграция локальной инфраструктуры с облачной платформой позволяет получить практически безграничную масштабируемость ровно в тот момент, когда она нужна.

Выбор между этими подходами — это не просто техническое решение, а стратегический ход, который определяет гибкость и итоговую стоимость всего вашего AI-направления.

Освойте Spot-инстансы

Одним из наиболее эффективных способов снижения затрат на вычисления является использование spot-инстансов (или прерываемых машин). Они позволяют арендовать те же GPU по существенно более низкой цене — экономия может достигать 80–90 % по сравнению с полной стоимостью.

Как это работает: облачный провайдер может забрать у вас инстанс в любой момент, если ресурсы понадобятся кому-то, кто платит полную цену. Уведомление об этом приходит заранее.

Несмотря на потенциальные риски, для многих AI/ML-задач такой подход оказывается весьма эффективным. Если процесс обучения модели можно прервать и возобновить с последней сохранённой точки (чекпоинта), то работа возобновится без значительных потерь.

Когда это работает:

-

Обучение моделей с частыми чекпоинтами. Если вы сохраняете прогресс каждые 15-30 минут, в худшем случае вы потеряете полчаса работы, а не целые сутки.

-

Распределенное обучение. Когда у вас работают десятки или сотни инстансов, потеря нескольких из них не останавливает весь процесс.

-

Задачи, не критичные ко времени. Эксперименты, R&D, обработка больших датасетов.

Использование spot-инстансов требует зрелых процессов и устойчивой архитектуры, однако при правильной организации обеспечивает существенное сокращение расходов и повышает экономическую эффективность AI-инфраструктуры.

Подводим итоги

Оптимизация затрат на GPU — это выстраивание культуры правильного потребления ресурсов. Это путь от простого вопроса «Какой GPU мне нужен?» до создания полностью автоматизированной системы, где оборудование никогда не простаивает.

Каждый из рассмотренных шагов помогает превратить расходы на GPU в управляемый актив, повышающий эффективность работы AI-команд.

Но главная цель не только в снижении затрат. Цель — построить эффективную AI-инфраструктуру, где ваши команды могут проводить больше экспериментов и быстрее получать результат. Ведь в мире AI побеждает не тот, кто тратит больше, а тот, кто тратит умнее.